ox1de

-

Zawartość

45 -

Rejestracja

-

Ostatnio

Posty napisane przez ox1de

-

-

Owszem nie był by to problem ale teraz trzeba sobie odpowiedzieć jakie korzyści przyniesie mi ZFS wzgledem innych mniej wymagających systemów plików przy takiej infrastrukturze jaką mam teraz w firmie, Tak naprawdę to nie jest jakiś kluster obliczeniowy, czy gigantyczny system bazodanowy, to będzie bardziej przechowalnia z wysoką dostępniością.

A tyle TB dlatego że przy RIPie plików do druków wielkoformatowych generują się spore pliki, a wszystkie projekty z zeszłych lat maja być przechowywane, taka polityka.

EDIT

Owszem jest ERP z bazą MSSQL ponad 50GB, serwery terminali na MS, VPN, i inne pierdoły, ale wydaje mi sie żę te "mniej wymagające" systemy plików bez problemu to uciągną i wcale nie będą się gorzej spisywać. Nie ma sęsnu wytaczać armaty na muche, tak mi się wydaje.

-

aaaaa kumam już, faktycznie pomyliłem tematy

To nie ja mam półki na ext4 puki co, w tym wypadku tez zrobię rozeznanie jak to wygląda, dzieki za sugestie

To nie ja mam półki na ext4 puki co, w tym wypadku tez zrobię rozeznanie jak to wygląda, dzieki za sugestie

Edit:

Czyli jak wszystko ma swoje wady i zalety, ja mam jedna partycje na ext4 22TB i działa do dobrze, ale jeśli faktycznie ZFS ciągnie tyle zasobów to troszkę nie fajnie bo musze mieć mega serwer żeby to obsłużyć a będę miał 3 takie półki i możliwe ze zwieksze ich zasoby do 46TB i co wtedy ?

-

Będę używał sieciowego systemu plików, NFS z opcja HA, muszę udostępnić te zasoby na inne serwery pod maszyny wirtualne.

-

Także buduje redundantnie z tym że do zastosowań produkcyjnych w firmie z półkami dyskowymi 24 - 48 TB A którą wersje DRBD męczysz? Ja będe testował ostatnią stabilną czyli chyba 8.x

Właśnie chłopaki jeszcze takie małe pytanie, co w momencie gdy będę chciał rozszerzyć pojemność półek wymieniając dyski z 2TB na 4TB, Lub jeśli będę chciał dołożyć kolejne zasoby do klastra (kolejną półkę? Jak taki proces wygląda?

-

A widzisz, dzięki za naprostowanie.

-

A więc, te 2 dni dały mi jeszcze troszkę więcej wiedzy, znowu poczytałem.

Stworzyłem GlusterFs-a sprawdziłem jak to funkcjonuje, nie robiłem żadnych testów wydajnościowych póki co, bo prawda jest taka że to będzie pierwsze takie wdrożenie dlatego na razie obeznałem się z mechanizmami.

Doszedłem do punktu w którym zapadł decyzja co do podłączenia zasobów replikowanych do proxmoxa, i pozostanie to nadal NFS tylko w wersji HA z heartbeat lub Pacemaker + Gluster lub DRBD. Co do mechanizmu replikacji będę musiał zrobić testy wydajnościowe, ale to w przyszły tydzien jak dostane kolejne dwie półki dyskowe i serwery.

Pozostała mi jeszcze kwestia tych "split brain" o którym była wcześniej mowa, domyślam się że to też można jakoś zautomatyzować, ale to będzie problem do rozwiazania gdy go wygeneruje już na pełnoprawnym środowisku podczas testów oraz rodzaju replikacji active:active lub active:passive.

A no i OS na to muszę jakiś wybrać

Albo debian albo CentOS, nie mogę się zdecydować

Albo debian albo CentOS, nie mogę się zdecydować

-

Ok. marca bede chcial juz wirtializowac mssql produkcyjnego Zrobilem wirtualne srodowisko testowe z dyskami passthrough do kvm i bede testowac gfs i drbd. Potestuje rozne warianty i dam znac co mi z tego wyszlo i co wybralem.

-

BTW ox1de mówiąc macierze raczej ma na myśli półki dyskowe, więc można je traktować jako lokalny storage.

Dokładnie tak

I takie półki sa traktowane jako storage lokalny, no nic pozostaje testować i wybrać. W przyszłości chciałbym zrobić jeszcze cluster na baze produkcyjna MSSQL, baza ponad 50Gb i zapisy lub zmiany są dokonywane z sekundy na sekundę więc nie wiem czy active:passive się sprawdzi w przypadku nagłej smierci, dlatego pytałem o równoległe wysyłanie danych na obie półki co mogło by zniwelować niespójność danych chyba że się mylę.

I takie półki sa traktowane jako storage lokalny, no nic pozostaje testować i wybrać. W przyszłości chciałbym zrobić jeszcze cluster na baze produkcyjna MSSQL, baza ponad 50Gb i zapisy lub zmiany są dokonywane z sekundy na sekundę więc nie wiem czy active:passive się sprawdzi w przypadku nagłej smierci, dlatego pytałem o równoległe wysyłanie danych na obie półki co mogło by zniwelować niespójność danych chyba że się mylę.mcbarlo A jak z wydajnością względem "normalnej" macierzy? testowałeś z raidem pod spodem czy bez?

Jakiś automat do przełączania testowałeś?

Właśnie, ja mam RAID5 z 12x2TB HDD ciekawe jak to się zachowa.

-

DRBD w takim razie pierwsze do testowania, przetestuje 2 warianty activ:activ i activ:passive i potem GlusterFS w taki sam sposb, zobacze jak to funkcjonuje.

-

Akurat te macierze są stosunkowo tanie, dlatego własnie że nie są współdzielone, o ceny się nie martwcie, inny temat jest.

A dyski w serwerach tez będę wykorzystywał ale już w opcji passthrough do KVM jako stor w raid5 lub raid10 do MSSQLa.

Jeszcze pytanie w DRBD dane sa synchronizowane pomiędzy nodami po wysłaniu pliku na primary node czy zapisywane są na obu nodach jednocześnie? W GFS jest opcja active:active a w DRBD?

-

W przypadku połączenia dwóch macierzy DRBD jest perfekcyjne

Możesz to rozwinąć? Moja sugestia odnośnie GlusterFS była podyktowana tym że jest o nim chyba najgłośniej w sieci, potem znalazłem dużo tematów na temat Ceph.

Proxmoxa mam na wszystkich nodach w wersji 4.1 robiłem update-y tydzień temu znam go bardzo dobrze już 3 lata z nim pracuje i z wersji na wersje jest coraz przyjemniej

I jeśli RDBD okaże się faktycznie na tyle dobre dla moich potrzeb nic nie stanie na przeszkodzie aby wdrożyć je w życie.Drbd-9.0 is already available as prerelease, but not yet stable.

I jeśli RDBD okaże się faktycznie na tyle dobre dla moich potrzeb nic nie stanie na przeszkodzie aby wdrożyć je w życie.Drbd-9.0 is already available as prerelease, but not yet stable.Ciekaw jestem ile przyjdzie czekać.

EDIT 1

RDBD wymaga serwera monitora, a co się stanie gdy ten padnie ? Jest na to jakaś solucja?

-

Czytałem sporo na temat klastrowych systemów plików, i opinie są podzielone, Gluster 3.7 podobno też niczego sobie a tez potknąłem się o temat w którym pisali ze gluster jest zasobożerny (ale nie podali która wersja) i RDBD lepiej się spisywał. faktem jest że nigdzie nie znalazłem naprawdę sensownego testu wydajnościowego, porównania rozwiązań, przykładów wdrożeń lub ew. abstrakcji z macierzami dlatego tez nie wykluczam puki co żadnego rozwiązania i czekam na wypowiedzi ludzi którzy testowali te rozwiązania lub może maja inne bardziej skuteczne w przypadku mojej konfiguracji sprzętowej.

Aktualnie na tych serwerach które są już wirtualizowane stoją maszyny, serwer VPN, NAS SYNOLOGY, i kilka innych usług które przez NFS przechowywane są na macierzy po 10Gbitach, działa to bardzo fajnie jeden serwer odpada drugi, lub trzeci przejmuje role i odpala z automatu VM które zgasły na serwerze offline. Tylko jeszcze została ta druga macierz aby zabezpieczyć dane, a nawet trzecia dla świętego spokoju sugerując się trzecim prawem Murphy'ego

-

Niestety, można spiąć 2 macierze se sobą ale zawsze obsługuje je jeden serwer, taki typ macierzy. Dlatego myslałem o Gluserze w celu replikacji. Tak naprawdę ten typ macierzy rozszerza tylko storage serwera do którego jest podłączona, montowanie odbywa się lokalnie bo kontroler obsługujący macierz jest w serwerze podłączony kablem sas, generalnie jest to zasób lokalny.

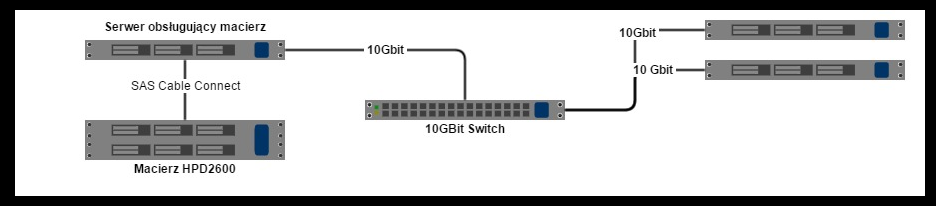

Wygląda to teraz tak:

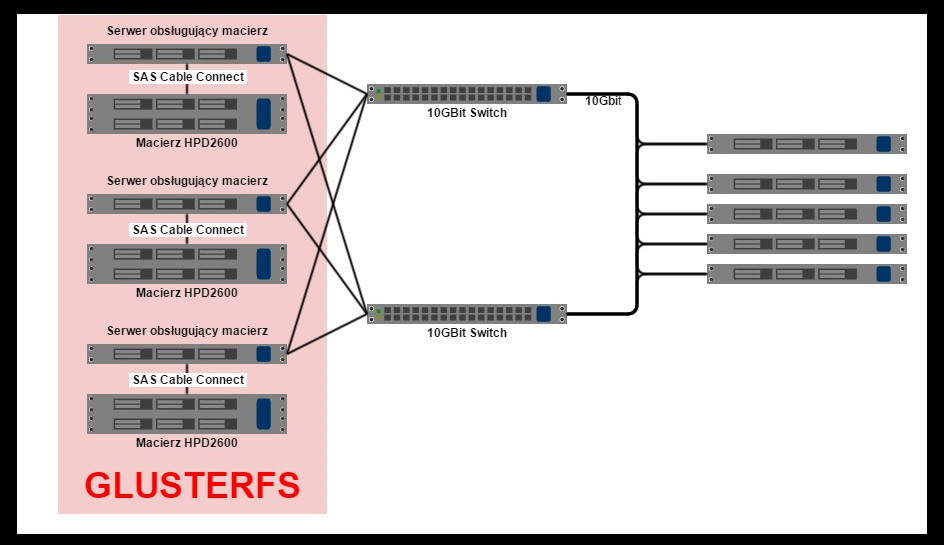

A chcę osiągnąć to:

I czy w takiej konfiguracji Gluseter sie sprawdzi ?

-

Macierz nic nie potrafi, i w tym problem, mogę druga macierz podłączyć do istniejącej szeregowo i będzie się replikować z automatu, ale nadal pozostaje single point of failure w postaci serwera do którego podłączona jest macierz przez kabel SAS do kontrolera.

I tego słabego punktu własnie chcę się pozbyć tworząc kolejne 2 macierze z serwerami które będą je obsługiwać i replikować dane po 10GBit-ach. Jakies propozycje

-

ostatnio bawię się z glusterem... mam 3 maszynki, dwie mają po jednym dysku dla glustera, na trzeciej mam odpalonego glustera tylko po to, żeby nfsa po localhoście podmontować i wydajność przetestować i z replikacją x2 i osiągnąłem jakieś 95% wydajności pojedynczego dysku...

Miło mi to słyszeć, pytanie jak Gluster będzie się zachowywać (wydajność, opóźnienia, obciążenia serwera do którego podłączona jest macierz) gdy stworzę go z 3 macierzy każda z 12 HDD (22TB RAID5) z replikacja ?

-

Witam. Posiadam małe środowisko wirtualne:

2 HP DL380 G5

1 HP DL380 G6

Macierz hp d2600 disk enclosure (22TB) współdzieloną z powyższymi nodami linkiem 10Gbit prot. NFS

Planuje kupić jeszcze minimum 3 HPDL380 G6 plus 2 macierze tego samego typu aby uczynić to środowisko produkcyjnym z wysoka dostępnością, tyle że jakiego mechanizmu użyć do replikacji danych na macierzach i automatyzacji failover. Naczytałem się o GlusterFS i wygląda obiecująco, ale zanim zacznę testy chce zaczerpnąć opinii ludzi którzy wdrażali już takie środowiska i powiedzą na co zwracać szczególna uwagę lub czego się wystrzegać ew. alternatywy odnośnie GFS tez są mile widziane.

-

Puki co korzystam tylko i wyłącznie z usług ovh i to od kilku ładnych lat i nie mam z nimi najmniejszych problemów. Vps tez mi sie unich podoba oprócz tego że ze lokalizacja serwera nie jest polska (na razie, bo mają plany co do vps-ów koło swoich CDN-ów w wawce) i to jest jedyny dla mnie ból.

Co do transferu, ovh nie określa ilości transferu na VPS-as

Warunki VPS na rok 2013.

W ramach usługi OVH gwarantuje dostęp do łącza o przepustowości 100 Mbps. Klienta

obowiązuje limit transferu dla przesyłanych danych w TB (terabajtach), naliczany dla ruchu wsieci OVH oraz poza siecią OVH.NIe chce mi sie porwadzić bezcelowych dyskusji, chce jedynie abyście Wy jako rozeznani w rynku polecili coś wartego uwagi, poważną firmę z polską lokalizacja w dobrej cenie. Dla mnie taką firmą jest ovh ale znam niczego poza nią.

-

Netdc.pl spełni twoje wymagania.

Śmiało polecam

Limit transferu!

Odpada. Po drugie jest 2 razy droższy z rozliczeniu miesiecznym.

Odpada. Po drugie jest 2 razy droższy z rozliczeniu miesiecznym.

-

Witam, poszukuje VPS takiego jak mam w tej chwili w ovh z tym że w lokalizacji polskiej.

1 vCore (2.0 GHz+)

512 MB

25 GB HDD

100 Mbps

Bez limitu transferu jak widać

Storage High Availability - Jaki mechanizm replikacji wybrac do sprzętu.

w Sprzęt serwerowy i Centrum Danych

Napisano · Raportuj odpowiedź

Tak czy siak sprawdzę, pewnie że tak, ale czy będę wdrażał zobaczymy